面壁智能刘知远:模型的知识密度将按每八个月增长一倍的速度发展

新京报贝壳财经讯(记者白金蕾韦英姿)“人工智能科学化、计算系统智能化、领域应用广谱化是大模型未来的三大主战场。”7月3日至7月10日,2024新京报贝壳财经年会在北京、深圳两地举行,面壁智能联合创始人、首席科学家,清华大学计算机系长聘副教授刘知远出席“‘通’往未来向新有AI”主题论坛,并以“大模型未来发展的三大主战场”为题发表主旨演讲。

刘知远在演讲中回溯了人工智能七十年的发展史,标定了大模型在其中的地位,并创造性地指出了“随着算力算法的发展,模型的知识密度将按照每八个月增长一倍的速度发展”。

刘知远以面壁智能在WAIC(世界人工智能大会)2024上最新发布的MiniCPM-S为例。“该模型目前有1.2B版本,已经能够达到约88%的稀疏度,让全链接层能耗降低至84%。同时它带来更加极致快速推理的能力,对比相对应的稠密模型,推理速度提高接近3倍,能够在性能不变的情况下,变得稀疏激活,从而让它的知识密度持续增强下去。”刘知远说。

面壁智能联合创始人、首席科学家,清华大学计算机系长聘副教授刘知远。

如何定位大模型在人工智能史上的地位?

应该如何准确地把握大模型在整个人工智能发展历史上的地位?在刘知远看来,人工智能七十年的发展,经历了高潮和低谷,但核心命题一直没有变,就是要让计算机掌握完成各种各样复杂任务的能力。

具体而言,上世纪五十年代的符号智能,是各领域专家用符号的形式总结各行业、各任务的知识,并用知识库等符号系统存储这些知识;跨越到上世纪九十年代,人类开始通过搜集相关任务的大量标注数据,通过有监督学习(自动)的方式,将任务知识储存在任务专用小模型里,这是专用智能;现在以大模型为代表的技术,实际上是更加通用的智能,从2018年开始探索出的(大模型)技术是一种比符号智能和专用智能更加通用的知识学习。基于此,他表示,大模型技术其实是实现了用序列化数据提取相关知识的通用方法。

“所以我们会清晰地看到,在通用框架的支持下,在序列预测学习方法的支持下,不管是文本数据、图象数据还是生命科学的DNA数据,还是人类使用各种各样工具的行为数据,都可以作为大模型学习的知识来源。”刘知远表示。可以理解为大模型的技术就是基于大数据和算力,去支持知识的持续积累,这也进一步证明了OpenAI提出的“规模法则(ScalingLaw)”,即模型参数规模越大,学到的知识越多,就会越涌现出更强大的智能。

回顾过去,刘知远判断,“我们经历了符号智能、专用智能,今天所在的位置是大模型的序幕,从OpenAI提出ChatGPT的第一个版本开始,到现在不过五六年时间。目前,我们正在加速迈向更加通用的人工智能,而大模型技术就是非常重要的技术基础。”

摩尔定律和大模型的发展规律

对于大模型发展规律,刘知远认为可以对标半导体领域的摩尔定律来进行理解。“我们看到半导体领域过去八十年,都在不断提高自己的芯片制程,以至于现在我们的手机、小型设备都拥有非常强大的算力芯片。”

摩尔定律最初是由英特尔公司的创始人之一戈登·摩尔在1965年提出的观察和预测。具体是指集成电路上可容纳的晶体管数量每隔一段时间就会翻倍,就是在相同的芯片上每段时间让它的算力提高一倍。这一发现成为了计算机行业的基础法则之一,也支持着计算设备快速完成小型化。

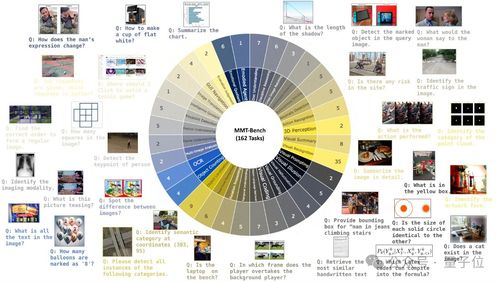

基于此,他猜测,有个类似于“摩尔定律”的规律来指引着大模型的发展。“我们发现过去的四年时间里,随着算力算法的发展,模型的知识密度按照每八个月增长一倍的速度在发展,知识密度的持续增强不仅发生在语言文本模型层面,在多模态大模型上也得到了验证。”刘知远说。

刘知远判断,类比于半导体行业,“我们更加需要注意未来大模型的‘制程’——我们需要不断提升模型的‘制程’,从而把更强的智能或者能力放到更少参数的模型里,面壁智能刘知远:模型的知识密度将按每八个月增长一倍的速度发展让大模型真正地飞入千家万户。”

为实现让大模型知识密度持续增强的愿景,刘知远提出了大模型未来的三大主战场,即人工智能科学化、计算系统智能化、领域应用广谱化。

具体而言,人工智能科学化将为能力涌现等关键机制建立科学理论,科学解释人工智能形成的原理。计算系统智能化则指大模型将与底层芯片、操作系统、数据管理、编程开发、网络通信深度融合;领域应用广谱化指将大模型应用于高精尖制造、科学发现等高度专业化场景中,让模型更好地适应各行各业智能化应用的需求,成为更好的助手。

面向未来,刘知远表示,“我们要在上述三大主战场进行布局,要持续推进人工智能的科学化,让模型知识密度不断增强,更好地、更广谱地赋能百业千行,所以我们也需要进行长时序建模,验证模型在高风险条件的可靠性,不断提升模型的响应速度。”

编辑段文平

校对张彦君